グラフベース半教師あり学習 (SSL) のLabel propagation (LP) とLabel spreading (LS) の違いを説明している文献があまりなかったのでそれについてちょっと書いてみる。SSL自体とかLP、LSについては以下の記事にまとめた文献がいい感じなのでそちらを参照。

半教師あり学習のモデル仮定 - でかいチーズをベーグルする

LPの元論文はこれ (PDF)

"Semi-Supervised Learning Using Gaussian Fields and Harmonic Functions", ICML2003

LSの元論文はこれ (PDF)

"Learning with Local and Global Consistency", NIPS2003

まとめ

- LPとLSの超概要、ランダムウォークとしての解釈、最適化問題としての解釈を書いた

- 軽い実験をした

- 基本的にLSの方がLPより高精度っぽい

- ラベル密度が小さい時は精度の差が開くっぽい

- ラベルにノイズが有る時は精度の差が開くっぽい

Label propagation

超概要

データをノード、データ間の類似度をエッジとしてグラフを構築し、そのグラフ上でラベル付きノードからラベル無しノードへラベルを「伝播」させる。近くにラベル1が多いノードはラベル1に、近くにラベル2が多いノードはラベル2に分類される感じ。解としてはラベルなしノードiのラベルがkである確率 が全てのiとkについて得られる(つまり行列

が全てのiとkについて得られる(つまり行列 が得られる)。ちなみにパラメータはない*1。

が得られる)。ちなみにパラメータはない*1。

データiのラベルを知りたいとき、グラフ上でデータiに対応するノードからランダムウォークをスタートする。このとき、ランダムウォークが初めにラベルがkであるラベル付きデータ(ノード)に到達する確率は、LPによって得られる解 と等しい。

と等しい。

- ラベル付きデータのラベルは変化しないという制約のもと、

- グラフ上で隣接しているノードは同じラベルを持ちやすい

というコスト関数を最小化する を求める。これがLPの解と等しい。

を求める。これがLPの解と等しい。

Label spreading

超概要

LPと同様にデータ間の類似度からグラフを構築し、ラベル付きノードからラベル無しノードへとラベルを伝播させる。LPとの違いはラベル付きノードのラベルも同時に再推定する点。つまり、LSはラベル付きデータ i のラベルが変化することを許す。例えば、ラベルが k であるラベル付きデータ i がたくさんのラベル k' データと類似していれば、i のラベルは k ではなく実は k' である確率が高いと出力する。これがLSのキモ。

パラメータは の一つで、どれだけ元のラベルを重視するかを表す。

の一つで、どれだけ元のラベルを重視するかを表す。 が大きいほどラベル付きデータのラベルは変わりやすくなる。パラメータのチューニングが必要という点ではLSの方が使いづらいのかな。ちなみに元論文では

が大きいほどラベル付きデータのラベルは変わりやすくなる。パラメータのチューニングが必要という点ではLSの方が使いづらいのかな。ちなみに元論文では と決め打ちされていた。

と決め打ちされていた。

LPと同様に、データ i のラベルを知りたいとき、グラフ上でデータ i に対応するノードからランダムウォークをスタートする。ただし確率 で隣接ノードのどれかに移動するが、確率

で隣接ノードのどれかに移動するが、確率 でデータ i に対応するノードに戻る。これを無限ステップ繰り返した時、ウォークがラベル k のラベル付きノードにいる確率はLSの出力

でデータ i に対応するノードに戻る。これを無限ステップ繰り返した時、ウォークがラベル k のラベル付きノードにいる確率はLSの出力 に等しい。

に等しい。

- ラベル付きデータは元々の自分のラベルからは変わりづらく、

- グラフ上で隣接しているノードは同じラベルを持ちやすい

というコスト関数を最小化する を求める。これがLSの解と等しい。パラメータ

を求める。これがLSの解と等しい。パラメータ は(1)と(2)の重みとして働く。LPではラベル付きノードがもともとの自分のラベルから変わらないような 制約 を入れていたが、LSでは制約にはなっていない。

は(1)と(2)の重みとして働く。LPではラベル付きノードがもともとの自分のラベルから変わらないような 制約 を入れていたが、LSでは制約にはなっていない。

実験

LPとLSはどっちを使ったらいいんだ、どう使い分けたらいいんだ、さっぱり分からん!ということで軽く実験をしてみた。scikit-learnに入ってるLPとLSの実装とDigitsデータを使った。LPとLSの他にふつーのSVMも比較した。

実験設定

Digitsデータを分類した。入力は画像データそのもので、ラベルはその画像がどの数字か(0から9)。1000サンプルのうちからランダムで一定の割合のノードのラベルを隠して分類を30回繰り返した。LP、LS、SVMのカーネルはRBFカーネルを使った。パラメータ(バンド幅、SVMのC)はグリッドサーチで決定。LSの は元論文と同様に0.99に決め打ちした。

は元論文と同様に0.99に決め打ちした。

- ラベル密度を変えた実験:全体のデータ数に対するラベル付きデータの割合を1%から50%まで変化させてどう精度が変わるかを見た。

- ラベルにノイズを入れた実験:ラベル付きデータのラベルをランダムに変更してどう精度が変わるかを見た。ノイズを入れる割合は0%から50%、ラベル密度は5%にした。

コードはここに置いたので興味のある人だけどうぞ。

ラベル密度を変えた実験

結果

- 期待通りラベル密度を小さくしていくとLPとLS共にSVMに勝った。

- LPよりLSの方がちょっと精度が高い。

- ラベル密度を小さくしていくとLPとLSの精度の差が少しずつ開いていく。

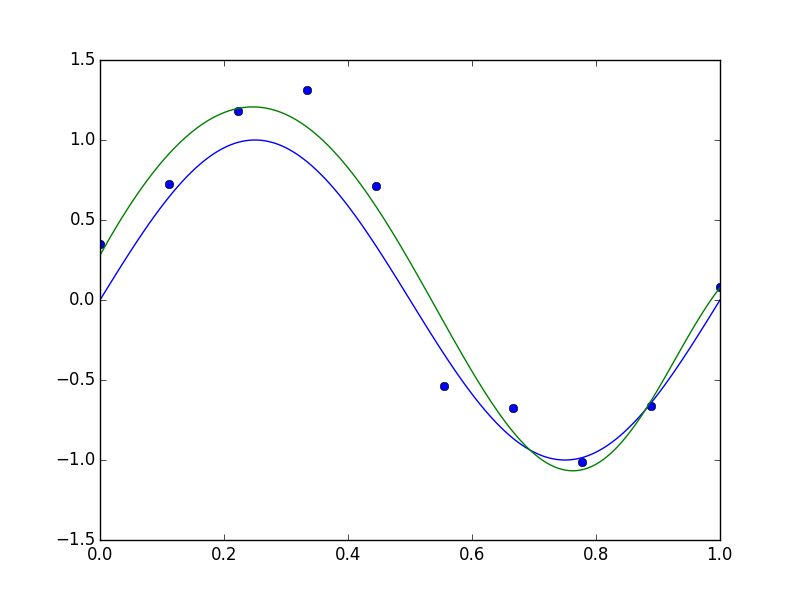

横軸はラベル密度、縦軸は精度、エラーバーは標準偏差。

考察(注意:個人の感想です)

ラベル密度が小さい時にSVMに勝てるのはまぁ周知の事実。と言うかそれが半教師あり学習の強み。

面白いのはラベル密度を小さくしていくとLPとLSの精度の差が開いたところ。なんでか考えたんだけど、多分LSのランダムウォークとしての解釈のところでランダムウォークが確率 で始点に戻るところが効いてるのかな。ラベル密度が小さいとランダムウォークがラベル付きノードに到達せずにどんどん始点から遠ざかってしまう事が多くなるけど、LSでは一定確率で始点に戻ることでそれがある程度防げるとか。

で始点に戻るところが効いてるのかな。ラベル密度が小さいとランダムウォークがラベル付きノードに到達せずにどんどん始点から遠ざかってしまう事が多くなるけど、LSでは一定確率で始点に戻ることでそれがある程度防げるとか。

ラベルにノイズを入れた実験

結果

- ノイズを入れる割合を大きくしていくとLPとLSの差が顕著に開く。

- SVMは悲惨な結果だけどLPとLSは高い精度を維持。

横軸はノイズの割合、縦軸は精度、エラーバーは標準偏差。

考察(注意:個人の感想です)

予想通りの結果になった。LSはもともとラベルがついてるデータのラベルを変更することも許してるから、ノイズでラベルが変わってしまったノードのラベルも正しく修正出来たってことだと思う。一方でLPとSVMはノイズで変わってしまったラベルも"信じきって"学習した結果精度が落ちてしまったって感じかな?ちょっとわからなかったのが、LPの精度もそこまで下がらなかったところ。ラベル密度も小さいし(1000サンプル中50個しかない)、そのうちの半分のラベルがランダムに変更されているのにこれだけ精度高いとは。。。

おわりに

今回実験した限りだとLSを使っとけば問題ないという結果になった。まぁでも「どんな場合でもLSの方が優れている」なんてことは無いしLPを使ったほうがいい場面も多分あるんだろうな。分からんけど。ちなみに今回の実験の設定ではSVMが悲惨な結果でLPとLSが圧勝してたけど、これは今回はLPとLSのモデル仮定(類似してるデータは同じラベルを持つ)が正しかったからであって、どんな場合でも(ラベル密度が小さければ)半教師ありがSVMとかの教師あり学習に勝てるわけじゃない。